把数据中心塞进办公桌,让智能开发快N倍

你的团队是不是还在这样干活?

数据同步等到天荒地老:几十个G的数据集,每次微调都要全量上传下载,咖啡都喝了三杯,进度条还在爬行...

GPU贵到肉疼:花大价钱买的显卡,却总在空转等数据,烧钱速度比模型收敛还快...

流程乱成一锅粥:PoC阶段飞起,一到生产环境就崩,全靠几位"大神"手动救火...

更扎心的是,隔壁团队用对工具,已经把你甩了三条街。

如果你也中枪,接下来的内容可能能帮助你。

"数据驱动"时代,你的基础设施跟上了吗?

过去我们痴迷算力,堆积GPU。但现在真相越来越清晰:算力是引擎,数据才是燃料。没有高效的数据流转体系,再强的算力也只是空转的发动机。

这正是OpenCSG和Dell联手破局的核心——从"算力驱动"转向"数据驱动",让数据成为智能创新的中心。

Dell的PowerScale智能存储系统,就是这个转变的关键。它不仅是存数据的"硬盘",更是智能时代的"数据中枢",让海量非结构化数据变成可流动的战略资产。

今天,两家技术巨头直接把"数据驱动的智能原生架构"打包成了一套开箱即用的解决方案,让你从传统IT丝滑进化到智能驱动的基础设施。

核心三板斧:每一斧都砍在数据命脉上

第一斧:Dell Pro Max with GB10 ——桌面上的"AI超算",但核心是数据预处理革命

这台看起来平平无奇的台式机,藏着数据中心级的Grace Blackwell架构。128GB统一内存全给GPU用,意味着你在工位上就能跑70B、200B大模型的量化版。

智能体开发、LoRA微调、多智能体调试,再也不用抢集群资源。下班前发现模型有问题?花10分钟改完,本地就能验证,不用提交工单等审批。

第二斧:Dell PowerScale——智能时代的"数据底座"

这是整个方案的基石,也是数据驱动转型的战略支撑。

PowerScale不是普通存储,它是为智能化原生设计的PB级数据湖:

单一命名空间:所有训练数据、模型Checkpoint、实验产物统一管理,告别"数据孤岛"

• GPU直连技术: Dell PowerScale通过直连 GPU,消除数据 I/O 瓶颈,让昂贵的计算资源接近满负荷运行,显著提升算力产出与投资回报。

• 智能分层:热数据全闪加速,冷数据自动归档,存储成本显著降低

没有PowerScale,你的TB级数据就是一堆死文件。有了PowerScale,它就是智能模型的"活水源"。

第三斧:OpenCSG CSGHub+Xnet——智能体时代的"操作系统"

这是整个方案的大脑和神经网络。

CSGHub是平台,Xnet是血管,二者一体构成了数据驱动的AI总控台:

CSGHub负责"管":将PowerScale里的数据资产、Dell Pro Max with GB10的算力、以及智能工作流全部串成闭环。模型、数据、实验记录统一纳管,团队经验沉淀为可复用的组织能力。

Xnet负责"流":让PowerScale中的数据像Git代码一样流转,只传改动、秒级同步、断点续传。它是连接算力与数据的"光速引擎"。

没有这对组合,PowerScale和Dell Pro Max with GB10只是孤岛。有了它们,就形成了一个活的数据驱动智算网络。

Xnet:让PowerScale里的数据"活"起来

传统方式传数据,就像用马车运货——不管东西多少,每次都要全套人马出发。

Xnet做了什么?它给PowerScale修了高铁,还装了智能调度系统。

三大绝招

1.Git式流转:PowerScale里的数据资产也有版本管理

想象一下:上午在Dell Pro Max with GB10上微调的模型,下午同事在集群就能从PowerScale拉取最新版本,就像git pull一样简单。

没有FTP、没有网盘、没有"老板.wetransfer.com",只有一行命令。

2.硬件灵魂共振:Dell Pro Max with GB10 +PowerScale+Xnet=数据驱动闭环

这三者不是简单连接,而是深度融合:

PowerScale:作为PB级数据湖,统一管理结构化与非结构化数据

• Dell Pro Max with GB10:从PowerScale按需取用数据,本地完成计算密集型任务

• Xnet:智能调度数据流向,确保热数据永远在GPU触手可及的位置

三位一体,形成"数据驱动的智能原生智算网络"。

3. 实测数据:PowerScale+Xnet效率提升不是吹的,经过戴尔深圳解决方案中心和OpenCSG技术专家的联合测试,相比传统HTTP/FTP全量传输,传输时间、模型同步延迟和多地协同项目周期均显著降低,GPU利用率大幅提高。

一句话:PowerScale里的数据等人变成了人驾御数据。

四个核心痛点,这套方案是怎么打穿的?

痛点1:数据提交等到天荒地老 变成:每次只传KB级改动 Xnet的增量机制,让GB级的数据提交变成KB级。数据驱动的精髓——只移动价值,不搬运垃圾。

痛点2:数据到处拷贝,存储成本爆炸 变成:PowerScale一份数据全链路复用 PowerScale作为单一数据源,训练、分析、报表全场景共用。数据驱动=数据只存一次,随处可用,存储和时间成本大幅下降

痛点3:GPU空转,钱在燃烧 变成:PowerScale直连GPU,算力压榨到极限 PowerScale通过GPUDirect技术绕过CPU,直连GPU显存,数据"零拷贝"到达计算核心。让百万投入的算力资源满负荷运转,实测利用率大幅提升。

痛点4:流程靠人肉,上线靠玄学 变成:CSGHub端到端工程化 "Prompt→Code→Build→Test→Release→Deploy→Operate→Retrain"八大阶段,在平台上一键闭环。数据驱动=全流程数据可追溯,PoC到生产不再是"跳崖",而是"走楼梯"。

这套方案适合谁?我们对号入座

初创公司(5-20人)

"我们只有一台Dell Pro Max with GB10,数据存在移动硬盘里"

够了。 一台Dell Pro Max with GB10 +PowerScale F210起步,就是完整的数据驱动智能工作站。

DeepSeek-R1 70B量化版在本地跑通,数据不用上云,安全又省钱。验证商业模式后再平滑扩展。

中型团队(20-100人)

"我们有集群,但数据管理一团乱"

CSGHub+PowerScale是你们的救星。PowerScale统一管理TB级数据资产,Xnet让多地办公/居家办公的研发效率不打折。杭州标注的数据,北京秒级同步。

大型企业/数字化转型部门

"我们要建企业级智能数据中台"

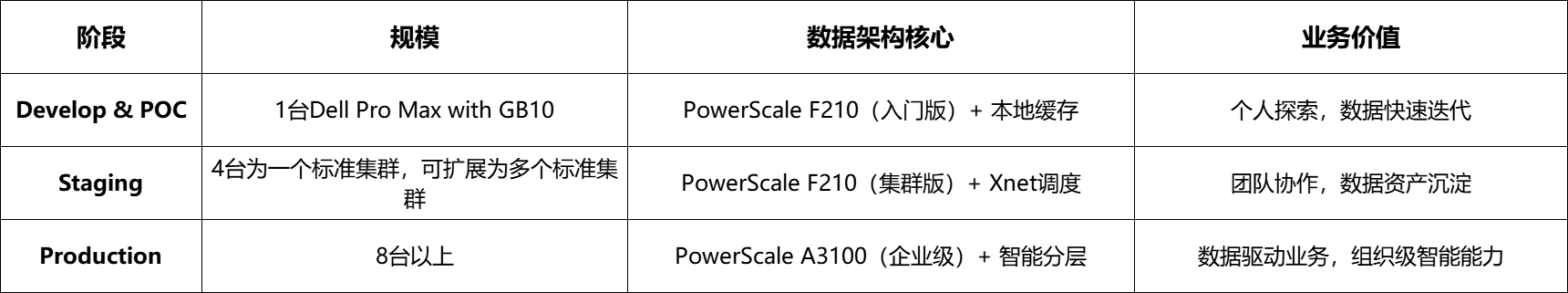

这是最完美的选择。从单机POC→团队Staging→生产Production, "PowerScale+CSGHub+Xnet"数据架构完全一致 。

告别"PoC飞快、生产崩溃"的噩梦,构建真正的企业级数据驱动智能平台。

适用场景:

制造业:智能转型中心,结合 CSGHub、Dell Pro Max with GB10 和 PowerScale,搭建高效的模型训练与优化平台;由 AgenticHub 驱动生产计划、质量检测和设备预测维护智能体,实现生产流程的智能化,提升生产效率与设备运维能力。

金融行业:合规+效率两手抓 某城商行构建本地智能投顾系统,数据不出域,满足监管要求。Dell 硬件提供稳定算力与数据保护,OpenCSG 实现跨场景的智能决策,CSGHub统一管理模型版本,AgenticHub驱动多智能体协作,帮助金融机构提升决策效率与风险管控能力。

政务系统:智能辅助审批,效率翻倍 以 AgenticHub 为智能操作系统,结合 CSGHub 的知识图谱与政务数据,推动智慧政务和 智能辅助决策系统落地,提升政务审批效率和公共服务响应速度。

智能教育:学生也能玩转大模型 将 Dell 强大算力与 OpenCSG 开放平台结合,建设智能教育实训基地,联通模型开发与教育教学,推动智能技术的普及与应用。大模型实验课从"只能看PPT"变成"人手一个真集群"。

从单机到企业集群,PowerScale数据架构始终如一

这套方案最牛的是:从小到大,数据驱动架构完全不变。

全程操作系统、容器编排、智能平台、数据架构完全一致,新节点上线从"数周"压缩到"数小时"。

即将到来的2026年智能竞赛,拼的是数据驱动的工程效率

当大模型能力越来越同质化,决定成败的不再是算法,而是数据流转的速度。

DeepSeek已经证明了"好模型不缺",现在缺的是 "让好模型快速产生价值" 的数据驱动基础设施。

这套方案,或许就是那张能让你"优雅上桌"的船票。

#智能基础设施 #数据驱动 #智能体时代 #企业数字化转型 #算力革命

思考:你们团队在智能项目落地中,数据管理最大的痛点是什么?